当我们一个辛苦的将新网站搞上线之后,最大的期待就是网站能够被百度等搜索引擎迅速的收录,这样我们的网站才有不断增加排名的机会,否则永远都会在无底洞中,难以有出头之日,自然也就很难获得不菲的利润。

那么是什么原因导致了新网站收录不容易呢?通常来说,百度对于新网站的渴求还是非常大的,如果一个新网站设计的相对比较新颖,同时也具有很好的内容,在收录方面一般不会出现很大的问题,不过这些网站的内容被深度收录就比较困难了,要想了解新站收录不易的真实原因,首先就要从百度蜘蛛的工作原理分析出发。

一般来说,搜索引擎在收录网站内容时,首先会通过一个专门的URL链接访问程序来遍历网络,而这个程序就是所谓的蜘蛛,又被叫做机器人。其中蜘蛛的称谓更加形象,因为互联网本身就是一个相互连接的蜘蛛网,而蜘蛛能够通过蜘蛛网爬行到各个地方,而蜘蛛程序就具有这种遍历爬行的作用。

如果你的网站能够被蜘蛛爬行的次数越多,那么收录的可能性就会急剧增加,以百度搜索引擎来说,百度蜘蛛通常会从自家的产品出发,比如百度贴吧、空间或者百科等然后遍历相关的网站。然后就是通过互联网上的一些大型门户网站,比如网易、新浪以及天涯,猫扑等,以此为结点遍历整个互联网。如果你的网站能够很快的被遍历到,说明你的网站权重就比较高,曝光率就高,那么收录的可能性就会越高。

蜘蛛收录内容的主要策略有两个,分别为广度优先和深度优先。所谓广度优先就是对某一个页面的所有链接进行抓取,然后找到下一个页面,接着抓取该页面的所有链接,这种方式显然能够一次性抓取更多的链接,所以从速度上更快。

而深度优先则是从网站的首页着手,分析首页的下个栏目页,然后再分析栏目页下面的专题页,在分析专题页下面的内容页等,通过逐级向下的方式进行遍历,当一个深度链接遍历完成之后,再到首页中遍历下一个,因此从速度上相对较低,但是能够更加全面的了解网站的内容。

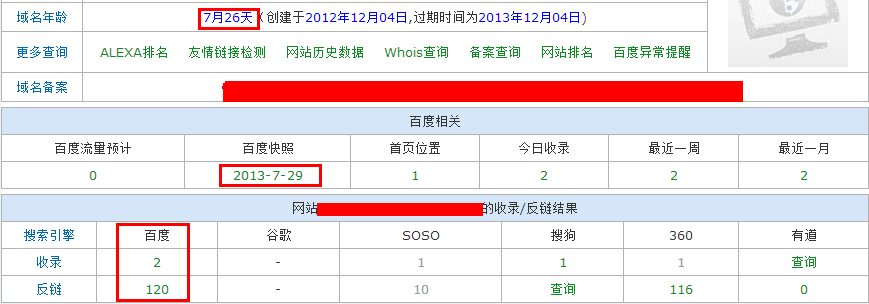

了解了网站蜘蛛的收录方式,我们想要提升网站的收录速度,就需要让网站能在很短的时间里就能够被百度蜘蛛抓取,而抓取的次数越多,那么收录就会更加快速。对此我们应该要尽可能的将网站的链接发布到百度的产品上,比如百度空间或者百度知道等,或者主动向百度提交,最后就是要将网站的外链发布到高权重的网站上,这样一来你的新网站的链接就能够在最短的时间里被抓取。

因为搜索引擎蜘蛛遍历网站是通过深度和广度两个方面进行综合,如果你网站内容更新相对频繁,且质量有保障那么就会得到百度蜘蛛的青睐,来到你网站的次数就会增多,收录的内容也会随着增多,所以每天定期更新网站内容,同时加强内容质量是非常关键的方式。

总而言之,网站被百度收录不易,收录之后想要提升排名更加不易,但是只要找准了节奏,严格按照百度蜘蛛爬行的原理进行,就能够有效提升网站的排名,进而让你收获更多的利润。

版权声明

本文仅代表作者观点,不代表本站立场。

本文系作者授权发表,未经许可,不得转载。

本文地址:/yunying/SEO/111356.html