把MongoDB作为循环队列的方法详解

我们在使用MongoDB的时候,一个集合里面能放多少数据,一般取决于硬盘大小,只要硬盘足够大,那么我们可以无休止地往里面添加数据。

然后,有些时候,我只想把MongoDB作为一个循环队列来使用,期望它有这样一个行为:

- 设定队列的长度为10

- 插入第1条数据,它被放在第1个位置

- 插入第2条数据,它被放在第2个位置

- ...

- 插入第10条数据,它被放在第10个位置

- 插入第11条数据,它被放在第1个位置,覆盖原来的内容

- 插入第12条数据,它被放在第2个位置,覆盖原来的内容

- ...

MongoDB有一种Collection叫做capped collection,就是为了实现这个目的而设计的。

普通的Collection不需要提前创建,只要往MongoDB里面插入数据,MongoDB自动就会创建。而capped collection需要提前定义一个集合为capped类型。

语法如下:

import pymongo

conn = pymongo.MongoClient()

db = conn.test_capped

db.create_collection('info', capped=True, size=1024 * 1024 * 10, max=5)

对一个数据库对象使用create_collection方法,创建集合,其中参数capped=True说明这是一个capped collection,并限定它的大小为10MB,这里的size参数的单位是byte,所以10MB就是1024 * 1024 * 10. max=5表示这个集合最多只有5条数据,一旦超过5条,就会从头开始覆盖。

创建好以后,capped collection的插入操作和查询操作就和普通的集合完全一样了:

col = db.info

for i in range(5):

data = {'index': i, 'name': 'test'}

col.insert_one(data)

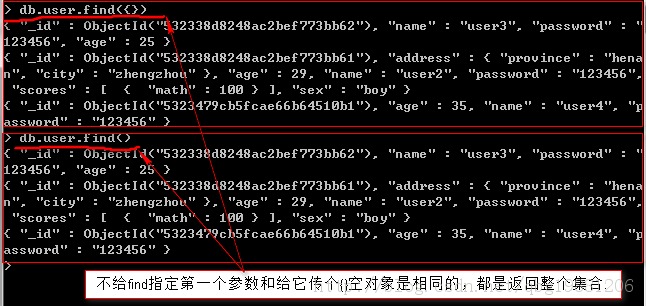

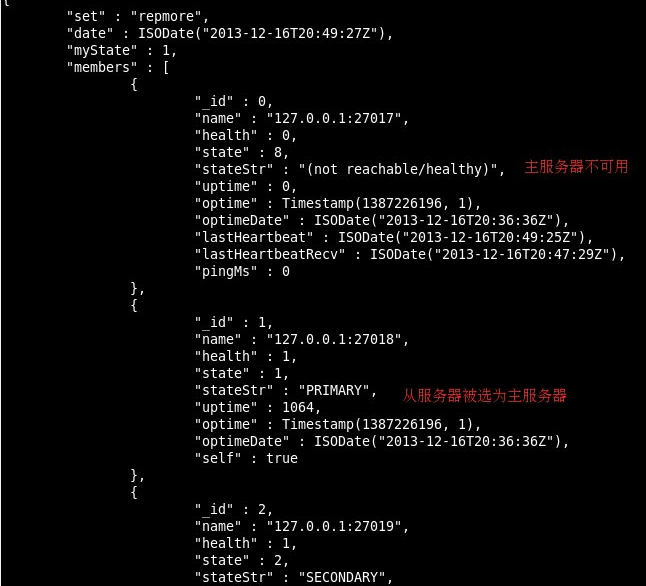

这里我插入了5条数据,效果如下图所示:

其中,index为0的这一条是最先插入的。

接下来,我再插入一条数据:

data = {'index': 100, 'name': 'xxx'}

col.insert_one(data)

此时数据库如下图所示:

可以看到,index为0的数据已经被最新的数据覆盖了。

我们再插入一条数据看看:

data = {'index': 999, 'name': 'xxx'}

col.insert_one(data)

运行效果如下图所示:

可以看到,index为1的数据也被覆盖了。

这样我们就实现了一个循环队列。

MongoDB对capped collection有特别的优化,所以它的读写速度比普通的集合快。

但是capped collection也有一些缺点,在MongoDB的官方文档中提到:

If an update or a replacement operation changes the document size, the operation will fail.

You cannot delete documents from a capped collection. To remove all documents from a collection, use the drop() method to drop the collection and recreate the capped collection.

意思就是说,capped collection里面的每一条记录,可以更新,但是更新不能改变记录的大小,否则更新就会失败。

不能单独删除capped collection中任何一条记录,只能整体删除整个集合然后重建。

总结

到此这篇关于把MongoDB作为循环队列的文章就介绍到这了,更多相关MongoDB作循环队列内容请搜索潘少俊衡以前的文章或继续浏览下面的相关文章希望大家以后多多支持潘少俊衡!

版权声明

本文仅代表作者观点,不代表本站立场。

本文系作者授权发表,未经许可,不得转载。

本文地址:/shujuku/MongoDB/104292.html